/image%2F1490480%2F20230303%2Fob_ed093c_de-la-nebuleuse-protosolaire-au-system.jpg)

Aujourd’hui, toute personne s’intéressant quelque peu à l’astronomie ou à la paléontologie sait que la Terre est âgée d’environ 4,5 milliards d’années et qu’elle est née approximativement en même temps que son étoile, le Soleil. Il n’en fut pas toujours ainsi : vers le milieu du XIXème siècle, deux écoles de pensée s’opposaient sur l’âge véritable de notre planète et les congrès scientifiques sur cette question donnaient alors lieu à des disputes parfois violentes, voire à quelques empoignades mémorables ; en effet, les physiciens avançaient l’âge maximal de 50 millions d’années tandis que les géologues parlaient plutôt en termes de centaines de millions d’années (ce qui était également l’opinion de Darwin qui pensait – à juste titre – qu’il fallait beaucoup de temps pour que les espèces évoluent et se transforment). Sans oublier tous ceux qui, appliquant à la lettre les enseignements des textes bibliques – et il y avait parmi eux quelque savants –, ne démordaient pas d’une création de la Terre remontant à environ six mille ans. Cette querelle – il s’agissait effectivement plus d’une polémique et même d’une dispute que d’une simple controverse – dura un demi-siècle ! Ce fut probablement le désaccord le plus long et un des plus virulents ayant jamais opposé des scientifiques de premier ordre et il ne me semble pas inintéressant de revenir sur les arguments des uns et des autres.

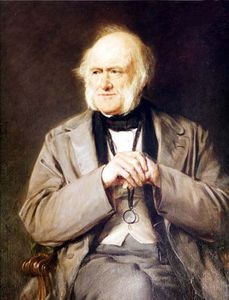

Le point de départ : Charles Lyell

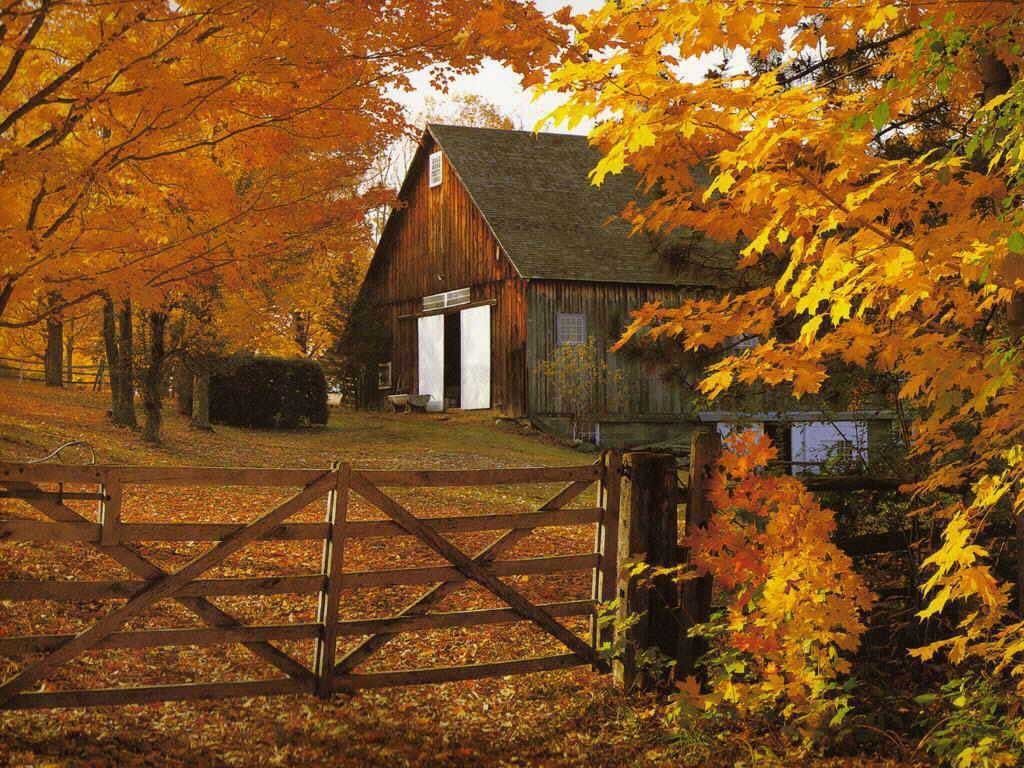

Né en 1797, Charles Lyell se destinait en fait à une carrière de droit mais il était passionné par la géologie qu’il avait toujours plus ou moins pratiquée. En 1828, Lyell voyage en Italie et dans le sud de la France : à cette occasion, il étudie diverses couches géologiques et leur trouve une unité en ce sens que ces différentes strates peuvent toutes être classées selon les fossiles d’animaux marins qu’elles renferment. Il en déduit une notion de continuité dans le temps, un temps qui ne peut être que nécessairement assez long. Deux ans plus tard, il commence à publier ses « principes de géologie », un véritable « pavé dans la mare » du catastrophisme qui prévalait à l’époque.

pratiquée. En 1828, Lyell voyage en Italie et dans le sud de la France : à cette occasion, il étudie diverses couches géologiques et leur trouve une unité en ce sens que ces différentes strates peuvent toutes être classées selon les fossiles d’animaux marins qu’elles renferment. Il en déduit une notion de continuité dans le temps, un temps qui ne peut être que nécessairement assez long. Deux ans plus tard, il commence à publier ses « principes de géologie », un véritable « pavé dans la mare » du catastrophisme qui prévalait à l’époque.

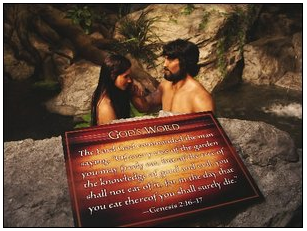

En ce temps-là, en effet, à la suite de Cuvier (et d’autres grands noms), on pensait que la Terre s’était créée très rapidement (en quelques milliers d’années) à cause d’événements violents, catastrophiques (d’où le nom de la théorie) comme, par exemple, le Déluge. Cette approche avait par ailleurs le gros avantage de ne pas brusquer les esprits religieux de ceux qui accordaient à la Bible le statut de témoignage authentique du passé. Lyell comprend qu’il remet en question bien des idées reçues mais il a une certitude : pour obtenir les couches géologiques qu’il a étudiées, il faut du temps et non des événements brutaux. Il redonne alors toute leur place aux idées de James Hutton, un géologue qui, quelques années plus tôt, avait avancé que la Terre s’était formée graduellement et que les éléments qui avaient permis cette création étaient encore présents et actifs. Pour Hutton, la Terre était « infiniment » vieille et il avait appelé sa théorie « uniformitarisme » (ou actualisme), expliquant que les transformations observées des roches et des océans en un endroit précis s’étendaient forcément sur une  durée de temps obligatoirement fort longue (on ne connaissait pas encore la tectonique des plaques) mais, à l’époque, il ne fut guère écouté. Lyell défendit donc cette approche aux dépens du catastrophisme ambiant et cela devait avoir une grande importance dans la suite des événements.

durée de temps obligatoirement fort longue (on ne connaissait pas encore la tectonique des plaques) mais, à l’époque, il ne fut guère écouté. Lyell défendit donc cette approche aux dépens du catastrophisme ambiant et cela devait avoir une grande importance dans la suite des événements.

En effet, quelques années plus tard, Charles Darwin croit reconnaître dans diverses espèces vivantes (mais également disparues) des ressemblances qui ne peuvent s’expliquer que parce que ces espèces dérivent les unes des autres (voir le sujet : les mécanismes de l’évolution). Darwin avait lu avec attention les principes de géologie de Lyell et avait compris ce qu’ils impliquaient : la transformation – ou plutôt l’évolution – des espèces devenait crédible s’il lui était accordé un laps de temps suffisant ce que précisément le catastrophisme ne pouvait pas lui offrir. Après avoir longtemps hésité, Darwin publie « l’origine des espèces » en 1859, non sans insister sur tout ce qu’il doit à Lyell, et le livre entraînera les remous que l’on sait. Darwin, se basant sur une évaluation empirique de l’érosion de la croute terrestre, se risque à avancer pour l’âge de la Terre une date qui lui paraît compatible avec la théorie qu’il défend : 300 millions d’années. Mais devant la levée de boucliers des catastrophistes, dans la seconde édition de son livre, il renonce à donner un chiffre tout en continuant à proclamer que Lyell a forcément raison, ce dernier étant d’ailleurs en retour un des premiers scientifiques de renom à le soutenir.

La contestation : Lord Kelvin

William Thomson – plus connu sous le nom de Lord Kelvin – était un très célèbre physicien puisqu’il avait – entre autres - donné son nom à une échelle de température absolue : le kelvin (la température de 0 K est égale à -273,15 °C et correspond au zéro absolu). Or, il était très dubitatif quant à la théorie de Darwin et, plus encore, sur les échelles de temps défendues par Lyell : il chercha donc à démontrer que tous ces gens-là se  trompaient… Il entreprit de s’appuyer sur les lois de la thermodynamique pour évaluer l’âge de la Terre et, d’emblée, une certitude s’imposa à lui : la Terre et le Soleil devaient être relativement jeunes sinon les deux astres ne seraient plus – et depuis longtemps- que des corps froids et inhabitables ; il était impossible, selon Kelvin, que les géologues aient raison car les chiffres qu’ils proposaient – des centaines de millions d’années – étaient bien trop élevés et, pour tout dire, fantaisistes.

trompaient… Il entreprit de s’appuyer sur les lois de la thermodynamique pour évaluer l’âge de la Terre et, d’emblée, une certitude s’imposa à lui : la Terre et le Soleil devaient être relativement jeunes sinon les deux astres ne seraient plus – et depuis longtemps- que des corps froids et inhabitables ; il était impossible, selon Kelvin, que les géologues aient raison car les chiffres qu’ils proposaient – des centaines de millions d’années – étaient bien trop élevés et, pour tout dire, fantaisistes.

La réputation mondiale de Lord Kelvin était alors telle que les géologues ne purent que s’incliner. Quelques années plus tard, en 1862, Kelvin publia le résultat de ses travaux sur la diffusion de la chaleur dans l’espace qui concluaient à un âge maximal de la Terre ne pouvant en aucun cas dépasser 100 millions d’années. C’était bien peu pour les géologues qui se demandèrent alors s’ils n’avaient pas sous-estimé les caractéristiques physiques de l’érosion de la croûte terrestre et très dérangeant pour un homme comme Darwin qui trouvait que 100 millions d’années, c’était décidément très insuffisant pour expliquer le long cheminement de l’Evolution, mais bon… Seul, Thomas Huxley, ami proche du naturaliste et grand vulgarisateur de la théorie de l’Evolution, n’accepta jamais les conclusions du physicien, estimant que celui-ci devait forcément se tromper quelque part mais sans pouvoir dire où, ni de quelle manière… Il demeura toutefois bien seul sur sa position et les chiffres de Kelvin finirent par s’imposer au point que même Lyell retira ses propres estimations de la réédition de ses « principes de géologie ». Darwin quant à lui rectifia, certes à contrecœur, certains passages de ses livres afin de prendre en compte une vitesse d’évolution des espèces bien plus rapide qu’il ne l’avait primitivement estimée.

En 1897, lord Kelvin publia de nouveaux travaux avec des calculs plus affinés qui concluaient à des chiffres encore plus petits : 20 à 40 millions d’années pour l’âge de la Terre ! C’était assurément un démenti définitif aux chiffres avancés par les tenants de l’authenticité biblique mais qui était loin de faire le bonheur des géologues et des Darwiniens. L’affaire en resta là jusqu’au début du siècle suivant et, la chose est assez rare pour être signalée, c’est à un physicien que l’on devra la levée de l’interdit jeté par un autre physicien…

La solution : Ernest Rutherford

C’est en effet un physicien qui va apporter les éléments de résolution  de cette querelle entre les géologues (et naturalistes) et les représentants de sa discipline… en donnant raison au camp opposé ! Cet homme providentiel est un Néo-zélandais travaillant en Angleterre et s’appelant Ernest Rutherford. Aujourd’hui, Rutherford est reconnu comme le père de la physique nucléaire mais à cette époque il n’en était encore qu’au commencement de sa prodigieuse carrière.

de cette querelle entre les géologues (et naturalistes) et les représentants de sa discipline… en donnant raison au camp opposé ! Cet homme providentiel est un Néo-zélandais travaillant en Angleterre et s’appelant Ernest Rutherford. Aujourd’hui, Rutherford est reconnu comme le père de la physique nucléaire mais à cette époque il n’en était encore qu’au commencement de sa prodigieuse carrière.

Nous sommes au tout début du XXème siècle et le Français Pierre Curie travaille depuis quelque temps sur le radium ; il se rend compte que, compte tenu de la petite taille des échantillons observés, ce corps dégage une chaleur sans commune mesure avec ce à quoi on aurait pu s’attendre. Rutherford arrive à la même conclusion quelques mois plus tard. Or, on savait que la Terre était très riche en ce type d’éléments ; dès lors, une évidence s’impose : notre planète possède le moyen de conserver sa chaleur et, contrairement à ce que défend Lord Kelvin depuis des années, elle ne se refroidit pas ou, en tout cas, seulement extrêmement lentement. Rutherford est à présent convaincu que la Terre est capable de conserver sa chaleur durant des millions d’années grâce à la radioactivité naturelle et, bien sûr, cela change tout ! Cet extraordinaire dégagement de chaleur, explique Rutherford, a une explication parfaitement logique puisqu’elle est la conséquence de la désintégration naturelle de certains atomes comme le thorium sur lequel il a longtemps travaillé et, bien sûr, le radium. Au début, cette découverte choque chimistes et physiciens pour lesquels, jusqu’à ce jour, il ne pouvait être question de destruction de la matière mais les travaux de Rutherford sont sans appel et, bientôt, tous se rendent à l’évidence (Pierre Curie mettra deux ans). En 1903, âgé seulement de 32 ans, Rutherford entre dans le cercle fermé des découvreurs de génie et reçoit une prestigieuse récompense, la médaille Rumford, décernée par la Royal Society.

C’est donc tout naturellement que, l’année suivante, il se rend à Londres  pour participer à un congrès sur l’âge de la Terre… en présence de Lord Kelvin en personne. Il n’a aucun mal à expliquer pourquoi le vieux physicien s’est trompé : ce dernier a tablé sur une dissipation progressive de la chaleur originelle sans savoir qu’il en existait une importante source au centre de la Terre : les lois de la thermodynamique ne peuvent donc pas s’appliquer telles quelles. Les géologues (et les partisans de la théorie de l’Evolution) avaient donc eu raison sans le savoir !

pour participer à un congrès sur l’âge de la Terre… en présence de Lord Kelvin en personne. Il n’a aucun mal à expliquer pourquoi le vieux physicien s’est trompé : ce dernier a tablé sur une dissipation progressive de la chaleur originelle sans savoir qu’il en existait une importante source au centre de la Terre : les lois de la thermodynamique ne peuvent donc pas s’appliquer telles quelles. Les géologues (et les partisans de la théorie de l’Evolution) avaient donc eu raison sans le savoir !

Lord Kelvin assista à la démonstration de Rutherford et aux débats qui s’ensuivirent mais jamais il n’accepta l’idée que la Terre pouvait être aussi âgée que le démontrait son jeune confrère car c’était admettre l’ouverture tant recherchée par les évolutionnistes, or, à cela, Lord Kelvin ne pouvait se résoudre tant il détestait l’idée même des travaux de Darwin. Quelques scientifiques continuèrent à soutenir sa position, plus par respect pour leur vieux maître que par conviction véritable, mais à sa mort, en 1907, on oublia définitivement ses calculs sur l’âge de la Terre. Les géologues avaient enfin trouvé l’explication de ces superpositions de strates qui les avaient tant intrigués et les Darwiniens le support scientifique nécessaire à la transformation des espèces dont ils avaient toujours été certains sans pouvoir le prouver.

L’âge de la Terre aujourd’hui

Les recherches sur l’âge réel de la Terre se sont poursuivies au fil des années. En 2002, des études portant sur des corps radioactifs rares comme l’hafnium et le tungstène ont encore repoussé l’origine de notre globe de quelques dizaines de millions d’années : on pense à présent que la Terre (et d’autres planètes) s’est constituée plus tôt et plus rapidement qu’on le croyait, probablement dans les 30 à 40 millions d’années du début du système solaire ce qui la fait arriver à un âge total de 4,6 milliards d’années, Soleil et planètes s’étant formées au quasi même moment. L’explication la plus probable est celle de l’explosion à cette époque d’une supernova proche dont l’onde de choc serait en quelque sorte venue « fertiliser » le nuage de gaz qui se trouvait à l’emplacement de notre système solaire actuel pour donner naissance, par agrégation progressive, à notre étoile, une naine jaune à longue durée de vie, et à son cortège de planètes. C’était il y a 4,6 milliards d’années et, pourtant, notre planète est toujours chaude comme en témoignent notamment les volcans qui, de temps à autre, viennent réveiller les consciences humaines. C’était il y a suffisamment longtemps pour que la Vie ait pu apparaître sur Terre, se diversifier et donner naissance au monde que nous connaissons aujourd’hui.

Images

1. du nuage protosolaire au système solaire (sources : lamaisondalzaz.com)

2. Charles Lyell (1797-1875) (sources : cosmology.tistory.com)

3. le Déluge, par Géricault (musée du Louvre) (sources : lettres.ac-rouen.fr)

4. Lord Kelvin (1824-1907) (sources : www.universitystory.gla.ac.uk)

5. Ernest Rutherford (1871-1937) (sources : commons.wikimedia.org/wiki)

6. coupe de la Terre (sources : geothermie.tpe.free.fr)

(Pour lire les légendes des illustrations, passer le pointeur de la souris dessus)

Mots-clés : Charles Lyell - catastrophisme - Georges Cuvier - James Hutton - uniformitarisme - tectonique des plaques - Charles Darwin - Lord Kelvin (William Thomson) - lois de la thermodynamique - Thomas Huxley - Ernest Rutherford - désintégration atomique

(les mots en gris renvoient à des sites d'informations complémentaires)

Articles connexes sur le blog

1. les mécanismes de l'évolution

2. distances et durées des âges géologiques

3. le rythme de l'évolution des espèces

4. la dérive des continents ou tectonique des plaques

Dernier sommaire général du blog : cliquer ICI

l'actualité du blog se trouve sur FACEBOOK

Mise à jour : 3 mars 2023

peut pas connaître en même temps la vitesse et la position d’une particule : dans le monde subatomique, on ne peut parler qu’en termes de

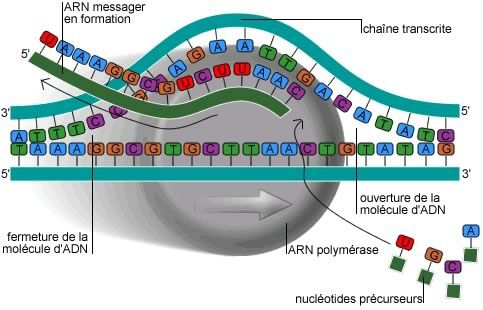

peut pas connaître en même temps la vitesse et la position d’une particule : dans le monde subatomique, on ne peut parler qu’en termes de  des protéines elles-mêmes régulatrices qui vont agir sur les cellules embryonnaires afin de leur faire quitter leur état indifférencié et les spécialiser, ici en cellules d’os, là en cellules du sang, là encore en cellule de pancréas, etc. Le fonctionnement de ces gènes est le suivant : des protéines régulatrices spécifiques vont se fixer sur un gène précis d’un chromosome et induire la formation d’enzymes qui vont copier ce gène sous la forme d’un transporteur (

des protéines elles-mêmes régulatrices qui vont agir sur les cellules embryonnaires afin de leur faire quitter leur état indifférencié et les spécialiser, ici en cellules d’os, là en cellules du sang, là encore en cellule de pancréas, etc. Le fonctionnement de ces gènes est le suivant : des protéines régulatrices spécifiques vont se fixer sur un gène précis d’un chromosome et induire la formation d’enzymes qui vont copier ce gène sous la forme d’un transporteur ( nombreuses que variées, on peut décrire à présent un « infiniment petit » biologique également fort riche en entités diverses. C’est vrai, la cellule humaine ne contient dans son noyau que 46 chromosomes constitués d’ADN enroulé en double hélice. Toutefois, cet ADN est lui-même composé de corps simples appelés

nombreuses que variées, on peut décrire à présent un « infiniment petit » biologique également fort riche en entités diverses. C’est vrai, la cellule humaine ne contient dans son noyau que 46 chromosomes constitués d’ADN enroulé en double hélice. Toutefois, cet ADN est lui-même composé de corps simples appelés  possible, ça ? Sans aucun doute. Je repense au célèbre exemple de la

possible, ça ? Sans aucun doute. Je repense au célèbre exemple de la /image%2F1490480%2F20230304%2Fob_a377a9_hasard-roulette-bille.jpg)

/image%2F1490480%2F20230304%2Fob_4fa009_soleil-taches.gif)

sur la séquence principale du

sur la séquence principale du /image%2F1490480%2F20230304%2Fob_76ed55_champ-magnetique-terrestre.jpg)

passe donc par différentes périodes de plus ou moins grande vigueur : on sait que son maximum d’activité correspond à la partie du cycle solaire où existe un maximum de taches ; c’est à ce moment là que les

passe donc par différentes périodes de plus ou moins grande vigueur : on sait que son maximum d’activité correspond à la partie du cycle solaire où existe un maximum de taches ; c’est à ce moment là que les  à des phénomènes spectaculaires : on marche à pied sur la Tamise gelée en 1607 et sur la Seine durant 35 jours de suite en 1777 (cette dernière gèlera 24 fois entre 1740 et 1859 mais plus aucune fois - sauf erreur - depuis 1891). En 1709, la méditerranée est gelée à Marseille et à Gènes. Le 21 janvier 1795, au Helder, la cavalerie française de Pichegru s’empare de la flotte hollandaise bloquée par les glaces et durant l’hiver de 1780, à New York, on allait à pied sec (ou plutôt à pied gelé) de Manhattan à Staten Island ce qui, pour ceux qui connaissent, est plutôt difficile à faire aujourd’hui. Autant de signes montrant que, durant ces quelques siècles, il a fait froid, très froid… Bon, mais quel rapport avec les taches solaires ?

à des phénomènes spectaculaires : on marche à pied sur la Tamise gelée en 1607 et sur la Seine durant 35 jours de suite en 1777 (cette dernière gèlera 24 fois entre 1740 et 1859 mais plus aucune fois - sauf erreur - depuis 1891). En 1709, la méditerranée est gelée à Marseille et à Gènes. Le 21 janvier 1795, au Helder, la cavalerie française de Pichegru s’empare de la flotte hollandaise bloquée par les glaces et durant l’hiver de 1780, à New York, on allait à pied sec (ou plutôt à pied gelé) de Manhattan à Staten Island ce qui, pour ceux qui connaissent, est plutôt difficile à faire aujourd’hui. Autant de signes montrant que, durant ces quelques siècles, il a fait froid, très froid… Bon, mais quel rapport avec les taches solaires ? culminerait avec son cortège de protubérances, de maxima magnétiques, de taches, etc. sauf que… il ne s’est rien passé ; on a eu beau scruter, rien à se mettre sous la dent : pas de tache, pas de début de reprise de cycle. Bon, se sont dit les astronomes, tout cela n’est pas bien grave et le Soleil n’est pas un ordinateur, il a quelques irrégularités : tout repartira en 2009 ! Mais au début d’octobre 2009,

culminerait avec son cortège de protubérances, de maxima magnétiques, de taches, etc. sauf que… il ne s’est rien passé ; on a eu beau scruter, rien à se mettre sous la dent : pas de tache, pas de début de reprise de cycle. Bon, se sont dit les astronomes, tout cela n’est pas bien grave et le Soleil n’est pas un ordinateur, il a quelques irrégularités : tout repartira en 2009 ! Mais au début d’octobre 2009,

suite notamment des textes religieux, que les espèces avaient été créées en une seule fois (sous-entendu par Dieu) et détruites, au moins pour certaines d’entre elles, de la même manière (par exemple à l’occasion d’un déluge, d’un formidable tremblement de terre ou d’une apocalypse). Précisons que le catastrophisme est le témoin d’une époque où l’on n’avait

suite notamment des textes religieux, que les espèces avaient été créées en une seule fois (sous-entendu par Dieu) et détruites, au moins pour certaines d’entre elles, de la même manière (par exemple à l’occasion d’un déluge, d’un formidable tremblement de terre ou d’une apocalypse). Précisons que le catastrophisme est le témoin d’une époque où l’on n’avait  c’est tout bêtement parce qu’ils n’existent pas ! S’appuyant sur la

c’est tout bêtement parce qu’ils n’existent pas ! S’appuyant sur la /image%2F1490480%2F20230304%2Fob_9db6bc_speciation-allopatrique.jpg)

trouva un autre en 1955, puis plus récemment une colonie entière en 1998, du côté des Comores… Par comparaison avec les nombreux fossiles de cœlacanthes que l’on possède, on a pu se rendre compte que les différences entre ceux-ci et les exemplaires actuels étaient somme toute

trouva un autre en 1955, puis plus récemment une colonie entière en 1998, du côté des Comores… Par comparaison avec les nombreux fossiles de cœlacanthes que l’on possède, on a pu se rendre compte que les différences entre ceux-ci et les exemplaires actuels étaient somme toute /image%2F1490480%2F20230304%2Fob_6723bc_chicxulub.jpg)

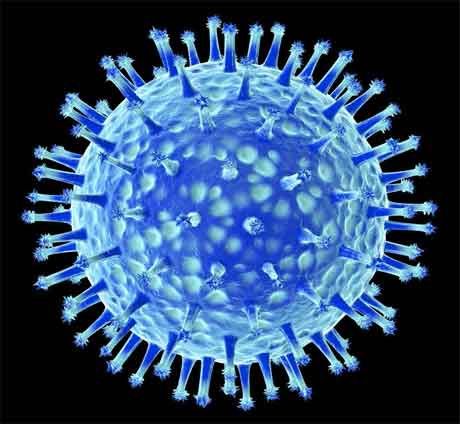

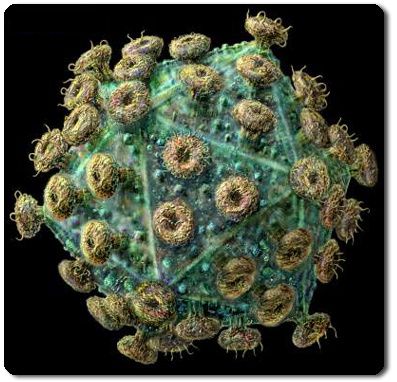

d’une affection dont ils sont porteurs. Car, on l’a déjà écrit dans un sujet précédent (voir sujet :

d’une affection dont ils sont porteurs. Car, on l’a déjà écrit dans un sujet précédent (voir sujet : la première fois avec ce type de souche virale. Et ce d’autant que ce n’est pas aussi simple qu’avec la grippe habituelle. En effet, selon les souches incriminées, la réaction du système immunitaire est variable : par exemple, pour la grippe habituelle, pas de problème et il ne faut qu’une toute petite quantité d’antigènes pour obtenir la réaction de défense de l’organisme (probablement parce que des souches voisines ont déjà circulé les années précédentes). C’est tout le contraire avec la

la première fois avec ce type de souche virale. Et ce d’autant que ce n’est pas aussi simple qu’avec la grippe habituelle. En effet, selon les souches incriminées, la réaction du système immunitaire est variable : par exemple, pour la grippe habituelle, pas de problème et il ne faut qu’une toute petite quantité d’antigènes pour obtenir la réaction de défense de l’organisme (probablement parce que des souches voisines ont déjà circulé les années précédentes). C’est tout le contraire avec la

suite du (léger) recul épidémiologique qu’on a sur cette maladie, on sait que certains groupes d’individus sont particulièrement menacés (ce qui n’est pas le cas avec la grippe habituelle), à savoir les

suite du (léger) recul épidémiologique qu’on a sur cette maladie, on sait que certains groupes d’individus sont particulièrement menacés (ce qui n’est pas le cas avec la grippe habituelle), à savoir les 100 000. Les personnes touchées par ce qu’on appelait jadis une forme de grippe dite « maligne » seraient, selon l’OMS,

100 000. Les personnes touchées par ce qu’on appelait jadis une forme de grippe dite « maligne » seraient, selon l’OMS,/image%2F1490480%2F20230228%2Fob_10d98e_fete-des-morts-au-mexique.jpg)

programmée (Au contraire, les cellules cancéreuses, immortelles, ont perdu cette faculté ce qui caractérise leur dangerosité). Cette apoptose survient naturellement sous certaines conditions comme le stress, des intoxications, des agressions diverses. Toutefois, il peut exister des dysfonctionnements de cette apoptose, soit qu’elle soit réprimée comme dans les cancers déjà cités, soit qu’elle soit mal contrôlée comme, semble-t-il, dans la maladie d’Alzheimer, la maladie de Parkinson, etc.

programmée (Au contraire, les cellules cancéreuses, immortelles, ont perdu cette faculté ce qui caractérise leur dangerosité). Cette apoptose survient naturellement sous certaines conditions comme le stress, des intoxications, des agressions diverses. Toutefois, il peut exister des dysfonctionnements de cette apoptose, soit qu’elle soit réprimée comme dans les cancers déjà cités, soit qu’elle soit mal contrôlée comme, semble-t-il, dans la maladie d’Alzheimer, la maladie de Parkinson, etc. d’un accident extérieur, ils finissent tous par mourir d’une cause interne (défaillance d’un organe majeur, rupture ou oblitération d’un vaisseau sanguin, etc.) ou d’une inadaptation aux conditions de leur environnement (la baisse, par exemple, de leurs défenses immunitaires les empêche de résister comme auparavant à une agression bactérienne ; ailleurs, une déshydratation a raison de leur résistance, etc.). Bref, en l’absence d’accidents évidents, on meurt tôt ou tard « de mort naturelle » comme disait Brassens et cela de manière variable selon les espèces considérées : remarquons au passage que les animaux n’ont évidemment pas le même taux de longévité (un rat vit 2 ans, une baleine 2 siècles alors que ce sont tous deux des mammifères) mais on est frappé de constater que, pour une même espèce, cette

d’un accident extérieur, ils finissent tous par mourir d’une cause interne (défaillance d’un organe majeur, rupture ou oblitération d’un vaisseau sanguin, etc.) ou d’une inadaptation aux conditions de leur environnement (la baisse, par exemple, de leurs défenses immunitaires les empêche de résister comme auparavant à une agression bactérienne ; ailleurs, une déshydratation a raison de leur résistance, etc.). Bref, en l’absence d’accidents évidents, on meurt tôt ou tard « de mort naturelle » comme disait Brassens et cela de manière variable selon les espèces considérées : remarquons au passage que les animaux n’ont évidemment pas le même taux de longévité (un rat vit 2 ans, une baleine 2 siècles alors que ce sont tous deux des mammifères) mais on est frappé de constater que, pour une même espèce, cette  mort est un mécanisme individuel qui devient un moteur de l’évolution pour l’espèce : les prédateurs ne veillent plus comme précédemment à l’équilibre démographique de leurs proies et il existe une

mort est un mécanisme individuel qui devient un moteur de l’évolution pour l’espèce : les prédateurs ne veillent plus comme précédemment à l’équilibre démographique de leurs proies et il existe une  relative au temps. Il proposa donc l’explication suivante : les

relative au temps. Il proposa donc l’explication suivante : les  milieu naturel et sauvage

milieu naturel et sauvage/image%2F1490480%2F20230402%2Fob_9fbe92_grippe-1.jpg)

H1N1

H1N1 Pour mémoire et au risque de me répéter, je rappelle qu’une

Pour mémoire et au risque de me répéter, je rappelle qu’une  nombre important de sujets sont particulièrement sensibles aux infections, quelles qu’elles soient, et donc la grippe. On pense évidemment à toutes les personnes dont les

nombre important de sujets sont particulièrement sensibles aux infections, quelles qu’elles soient, et donc la grippe. On pense évidemment à toutes les personnes dont les  quelque sorte que la grippe ne

quelque sorte que la grippe ne

les mêmes causes produisant les mêmes effets, la Vie existe aussi sur les autres planètes et le système solaire est forcément habité par d’autres êtres intelligents avec lesquels il ne suffit plus qu’à entrer en contact ! On scrute avec patience tous les astres du système solaire et on finit par s’en persuader : c’est

les mêmes causes produisant les mêmes effets, la Vie existe aussi sur les autres planètes et le système solaire est forcément habité par d’autres êtres intelligents avec lesquels il ne suffit plus qu’à entrer en contact ! On scrute avec patience tous les astres du système solaire et on finit par s’en persuader : c’est  avec un appareil de bonne facture et il confirme les observations de Secchi. Il décrit les mêmes lignes noires qu’il baptise également canali traversant des étendues brillantes (les continents) pour aller d’une tache plus sombre à une autre (les mers). Deux ans plus tard, il croit voir des « dédoublements » de ces canaux qu’il qualifie de

avec un appareil de bonne facture et il confirme les observations de Secchi. Il décrit les mêmes lignes noires qu’il baptise également canali traversant des étendues brillantes (les continents) pour aller d’une tache plus sombre à une autre (les mers). Deux ans plus tard, il croit voir des « dédoublements » de ces canaux qu’il qualifie de  abandonne tout pour se consacrer exclusivement à l’étude de la planète rouge (il sera par la suite le découvreur posthume de la planète naine

abandonne tout pour se consacrer exclusivement à l’étude de la planète rouge (il sera par la suite le découvreur posthume de la planète naine  bande de végétation d’une trentaine de km de part et d’autre, un peu à la façon de ce que l’on observe dans la vallée du Nil). Par la suite, l’observatoire de Lowell tirera de multiples clichés photographiques destinés à apporter la preuve irréfutable de la théorie, des clichés en fait assez flous et peu explicites mais quand on a la foi…

bande de végétation d’une trentaine de km de part et d’autre, un peu à la façon de ce que l’on observe dans la vallée du Nil). Par la suite, l’observatoire de Lowell tirera de multiples clichés photographiques destinés à apporter la preuve irréfutable de la théorie, des clichés en fait assez flous et peu explicites mais quand on a la foi… Antoniadi

Antoniadi d’un autre âge… qui subsistent encore dans l’inconscient collectif de nos contemporains comme le prouve la certitude absolue de certains concernant la présence

d’un autre âge… qui subsistent encore dans l’inconscient collectif de nos contemporains comme le prouve la certitude absolue de certains concernant la présence /image%2F1490480%2F20230228%2Fob_6790bb_toile-double-regulus-et-leo.jpg)

Pour essayer de comprendre ce qu’est la Vie, il est tout d’abord indispensable de connaître l’endroit où elle a pu apparaître, c'est-à-dire l’Univers qui nous entoure et dont nous sommes partie intégrante. L’astronomie, principalement, répond ici à cette recherche, tant d’un point de vue descriptif que prospectif.

Pour essayer de comprendre ce qu’est la Vie, il est tout d’abord indispensable de connaître l’endroit où elle a pu apparaître, c'est-à-dire l’Univers qui nous entoure et dont nous sommes partie intégrante. L’astronomie, principalement, répond ici à cette recherche, tant d’un point de vue descriptif que prospectif. univers ? Quels sont ses composants de base ? Voici quelques pistes de réflexion.

univers ? Quels sont ses composants de base ? Voici quelques pistes de réflexion. Sait-on comment est apparue la Vie telle que nous la connaissons ? Peut-on seulement définir ce qu’elle est ?

Sait-on comment est apparue la Vie telle que nous la connaissons ? Peut-on seulement définir ce qu’elle est ? Des milliards d’individus, des millions d’espèces nous ont précédés : comment expliquer ce long cheminement ?

Des milliards d’individus, des millions d’espèces nous ont précédés : comment expliquer ce long cheminement ? Comment la Vie se maintient-elle sur notre planète ? Quels sont ses moyens de survie ? Est-elle si fragile ?

Comment la Vie se maintient-elle sur notre planète ? Quels sont ses moyens de survie ? Est-elle si fragile ? notre passage dans ce monde si vaste ?

notre passage dans ce monde si vaste ? La structure de l’univers, l’histoire de la Terre et l’Evolution des êtres vivants telles que nous les apprend la science sont contestées par certains pour des raisons plus ou moins avouables. L’obscurantisme est encore bien présent dans notre monde. Retour sur quelques grandes controverses.

La structure de l’univers, l’histoire de la Terre et l’Evolution des êtres vivants telles que nous les apprend la science sont contestées par certains pour des raisons plus ou moins avouables. L’obscurantisme est encore bien présent dans notre monde. Retour sur quelques grandes controverses./image%2F1490480%2F20230219%2Fob_26c492_systeme-solaire-2.jpg)

de la réalité, les scientifiques comptent, eux, en temps négatifs). Nous trouvons alors :

de la réalité, les scientifiques comptent, eux, en temps négatifs). Nous trouvons alors : beaucoup plus loin puisque cela représente un peu plus de

beaucoup plus loin puisque cela représente un peu plus de  cette dernière (où le Soleil occupe une place relativement excentrée, voir le sujet

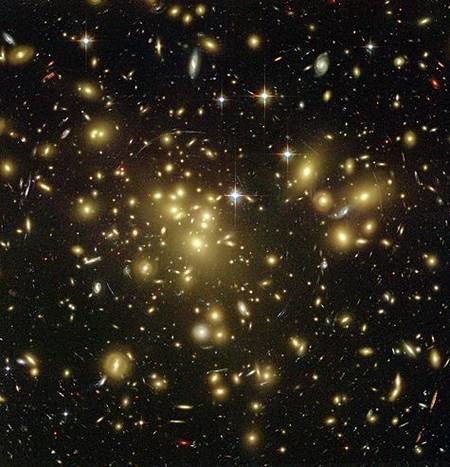

cette dernière (où le Soleil occupe une place relativement excentrée, voir le sujet  une centaine) également organisés en superamas mais ces amas sont si distants les uns des autres que, contrairement à ce qui se passe pour le groupe local auquel nous appartenons, leurs forces d’attraction ne peuvent jouer : de ce fait, ces amas de galaxies s’éloignent les uns des autres à la

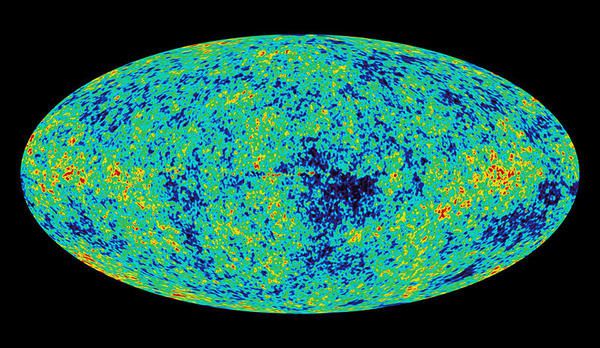

une centaine) également organisés en superamas mais ces amas sont si distants les uns des autres que, contrairement à ce qui se passe pour le groupe local auquel nous appartenons, leurs forces d’attraction ne peuvent jouer : de ce fait, ces amas de galaxies s’éloignent les uns des autres à la  enregistre des images de ce rayonnement, il regarde à 13,6 milliards d’années dans le passé, un chiffre qu’il me semble impossible de saisir et de vraiment comprendre autrement qu’intellectuellement…

enregistre des images de ce rayonnement, il regarde à 13,6 milliards d’années dans le passé, un chiffre qu’il me semble impossible de saisir et de vraiment comprendre autrement qu’intellectuellement…/image%2F1490480%2F20240420%2Fob_da5b95_toile-de-wolf-rayet-wr-124.jpg)

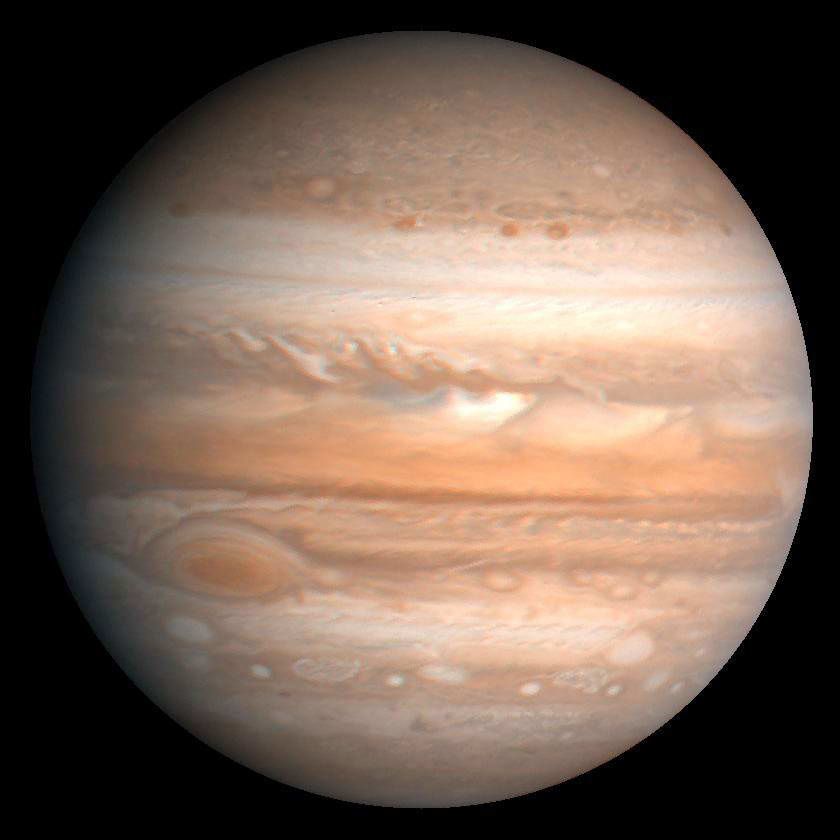

/image%2F1490480%2F20240213%2Fob_d2409a_jupiter-tourbillons-vus-par-juno.jpg)

/image%2F1490480%2F20231207%2Fob_babb88_nebuleuse-du-crayon.jpg)

/image%2F1490480%2F20230904%2Fob_d865b1_enrico-fermi.jpg)

/image%2F1490480%2F20230430%2Fob_25ae20_galaxie-cachee-ic-342.jpg)

/image%2F1490480%2F20230108%2Fob_68c405_voie-lactee-serge-brunier.jpg)